生成AIを取り巻く環境は急速に進化しており、PoC(概念実証)から本番展開へのスピードがこれまで以上に求められる時代になりました。そんな中、Microsoftが提供する Azure AI Foundry は、プロンプトの検証、モデルのテスト、マルチモーダルAIの活用までを一気通貫で実現できる、強力な開発基盤です。

本記事では、Azure AI Foundryの基本機能を押さえつつ、中級エンジニアが即戦力として活用できる実践的な使い方やユースケースを徹底解説します。GUIベースで操作できる「プレイグラウンド」機能や、言語・音声・画像モデルの組み合わせ活用など、効率的なAI開発に役立つ情報をわかりやすくお届けします。

Azure AI Foundryとは?

Azure AI Foundryは、Microsoft Azureが提供する生成AI活用のための統合プラットフォームです。大規模言語モデル(GPT)、画像生成(DALL·E)、音声認識・合成、自然言語処理など、複数のAIサービスをノーコード/ローコードで簡単に試せて活用できるよう設計されています。

どんなサービスなの?

Azure AI Foundryは以下のような特長を持った開発者・ビジネス担当者のためのAI実験場です:

- 直感的なGUIで、生成AIのテスト・評価・プロトタイピングが可能

- OpenAIモデル(GPT-4, DALL·Eなど)をAzure上で安全に使用

- 各種データ(テキスト、音声、画像)に対して分析・変換・生成が可能

- 統合されたプレイグラウンドで用途別にAIを試せる(チャット・音声・言語・画像など)

Azure AI Foundryの利用料金

Azure AI Foundryでは、従量課金制(使った分だけ支払う方式)が採用されています。モデルごとに異なる価格設定がされており、利用料は使用するモデルと、入力・出力のトークン数に応じて決まります。

具体的な料金は、Microsoft公式のAzure AI Foundry の価格で確認できます。利用前にシナリオごとの見積もりを行うことをおすすめします。

トークン数の目安

料金は通常「100万トークンあたり」で表記されています。以下に、100万トークンがどれくらいの情報量に相当するかの目安を示します。

| 項目 | 目安 |

|---|---|

| 日本語の文字数 | 約 75万〜80万文字(1トークン ≒ 0.75〜0.8文字) |

| 英語の単語数 | 約 75万語(1トークン ≒ 1語) |

| A4原稿用紙のページ数 | 約 1,500〜2,000ページ(1ページ ≒ 400〜500文字換算) |

| 書籍にすると | 文庫本 約8〜10冊分 |

| 音声にすると | 約80〜100時間相当の会話文字起こし(密度による) |

| 処理時間(API応答) | モデル・設定によるが、1回で処理しきれないため分割が必要(例えばGPT-4 Turboの最大は128kトークン) |

料金例:GPT-4oモデル

GPT-4o-2024-1120 Global の場合

- 入力:¥357/100万トークン

- 出力:¥1,428/100万トークン

例)

100万トークンの日本語を読み込み、英語に翻訳して同じく100万トークン出力した場合の合計費用

357円(入力)+1,428円(出力)=1,785円

OpenAIサービスの主なモデルと特徴

GPTシリーズ

| モデル名 | 発表日 | 備考 |

|---|---|---|

| GPT-3.5-Turbo | 2023年3月 | ChatGPT無料版で初登場 |

| GPT-4 | 2023年3月14日 | 高精度・マルチモーダル対応 |

| GPT-4-Turbo | 2023年11月6日 | 高速・低コスト・128k対応 |

| GPT-4o | 2024年5月13日 | テキスト・画像・音声統合 |

| GPT-4o mini | 2024年7月18日 | 軽量モデル(推定リリース) |

| GPT-4.5 | 2025年2月28日 | 最新モデル |

Oシリーズ

| モデル名 | 発表日 | 備考 |

|---|---|---|

| o1 | 2024年9月12日 | 小型・軽量モデル |

| o3 | 2024年12月20日 | 中量級モデル |

その他(画像生成系)

| モデル名 | 発表日 | 備考 |

|---|---|---|

| DALL·E 3 | 2023年10月5日 | 高品質な画像生成モデル |

Azure AI Foundryの活用事例

Azure AI Foundryは、音声・言語・画像といった多様な生成AI機能を備え、企業の業務効率化やサービス品質の向上に貢献します。ここでは、特に実用性の高い3つの活用シーンをご紹介します。具体的にどのような現場で、どのように使われているのかを見ていきましょう。

① 顧客対応の自動化(チャットボット・音声応答)

用途:カスタマーサポート、FAQ対応、音声IVR(自動応答)

活用機能:チャットプレイグラウンド、音声プレイグラウンド、発音評価

効果:

- 営業時間外の問い合わせにも対応可能に

- マルチ言語対応により、グローバル展開にも対応

- 顧客満足度と対応スピードの向上

② コールセンターの品質分析・要約

用途:通話記録の文字起こし、感情分析、要点抽出

活用機能:言語プレイグラウンド(感情分析・会話要約・PII抽出)

効果:

- クレーム対応やトラブル傾向の早期把握

- オペレーターごとの対応評価が容易に

- 会話の要約やキーワード抽出により、業務効率が大幅アップ

③ マーケティング用画像・音声コンテンツの自動生成

用途:プロモーション画像やナレーションの生成

活用機能:画像プレイグラウンド(DALL·E)、音声プレイグラウンド(TTS・アバター)

効果:

- 多言語・多国籍市場へのローカライズ対応も容易

- クリエイティブ制作のコストと時間を削減

- パーソナライズされた広告やSNS投稿を高速に展

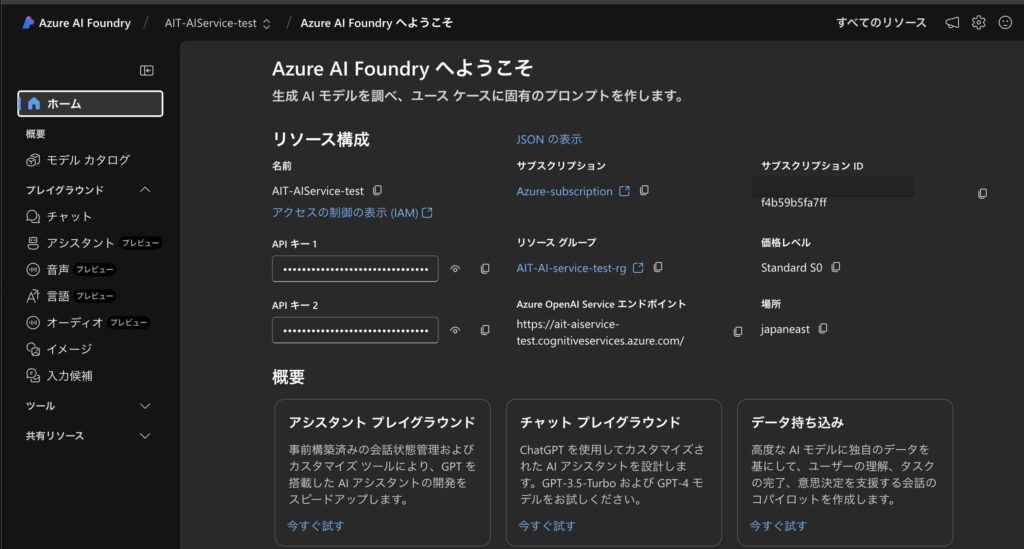

Azure AI servicesのデプロイ手順

Azure AI Foundryを利用するために必要な事前準備として、「Azure AI Services」の作成手順と、作成後に「Azure AI Foundryポータル」へアクセスする方法を、画像付きで丁寧にご紹介します。

Azureポータルにログイン

まずはAzureポータルにログインします。Microsoftアカウントを使用してログインしてください。

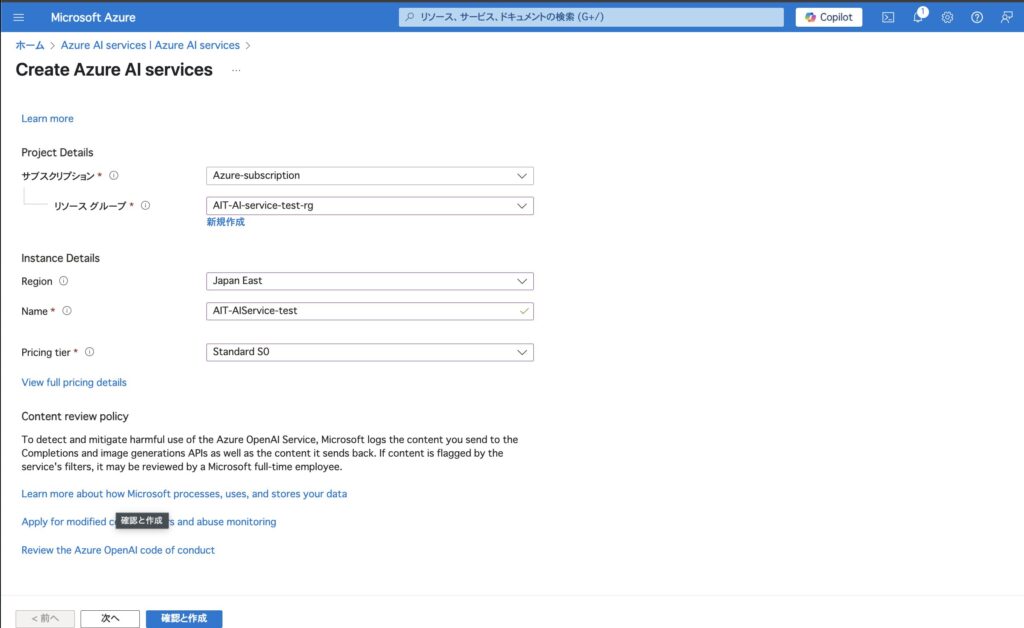

Azure AI Servicesの作成

左側メニューの検索バーに「Azure AI services」と入力し、該当のサービスをクリックします。

「+ 作成」ボタンをクリックして、新しいAIサービスの作成を開始します。

以下の情報を入力します。

- サブスクリプション:利用するAzureサブスクリプション

- リソースグループ:新規または既存のリソースグループを選択

- リージョン(地域):例)Japan East

- 名前:任意のサービス名

- Pricing tier:通常は「Standard S0」など

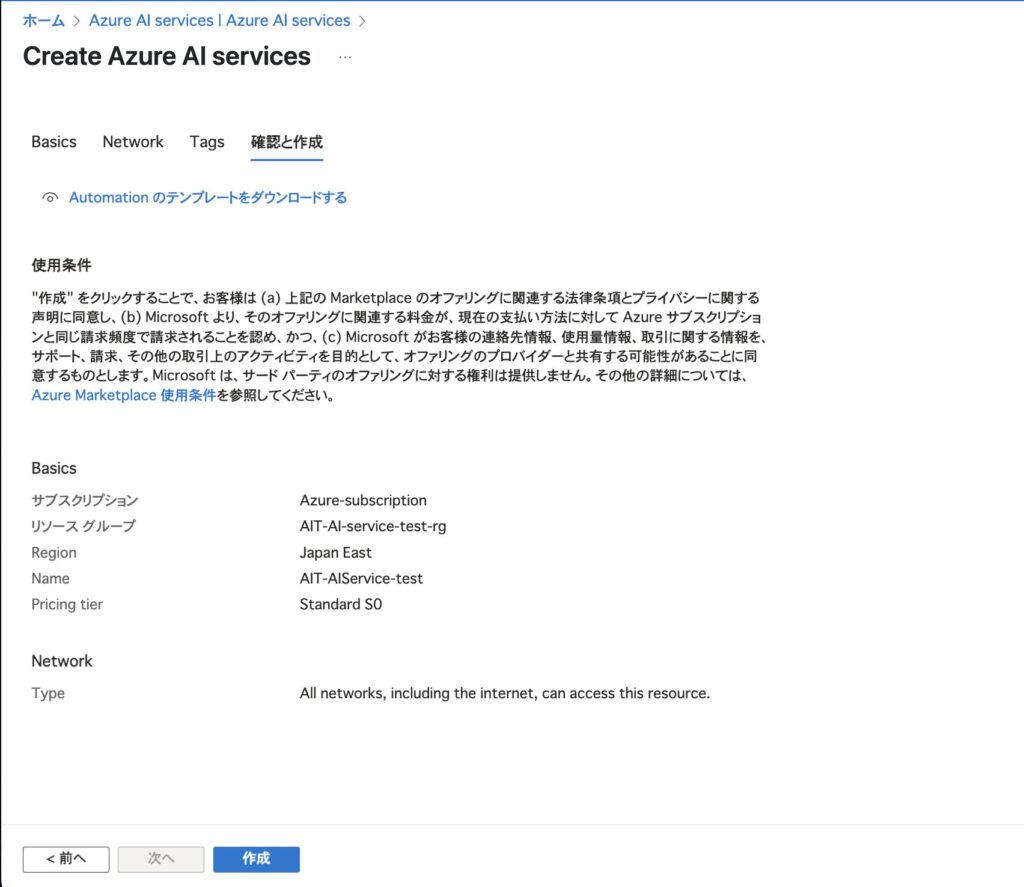

入力が完了したら、「確認と作成」へ進みます。

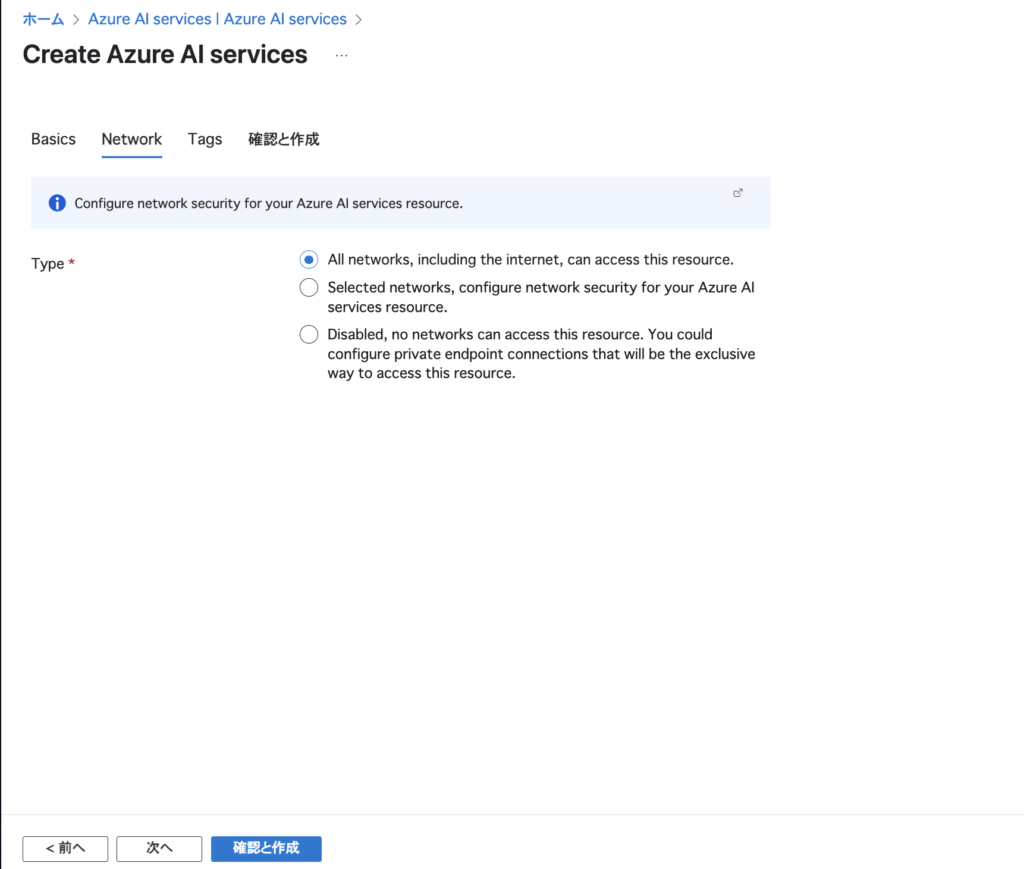

ネットワーク設定では、アクセスレベルを選択します。今回は「すべてのネットワーク(インターネットを含む)」を選びましょう。

最終確認画面で内容を確認し、「作成」をクリックします。

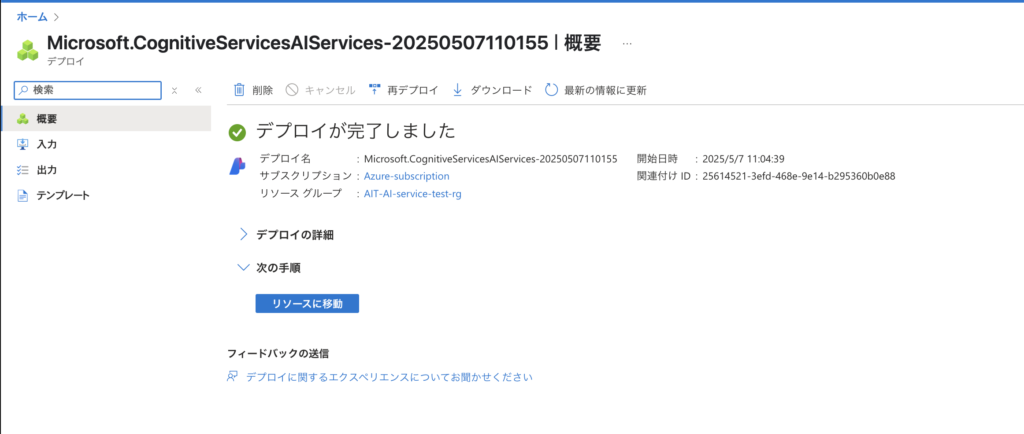

数分でデプロイが完了し、「デプロイが完了しました」という画面が表示されます。

「リソースに移動」ボタンをクリックして、作成したサービスの詳細に移動しましょう。

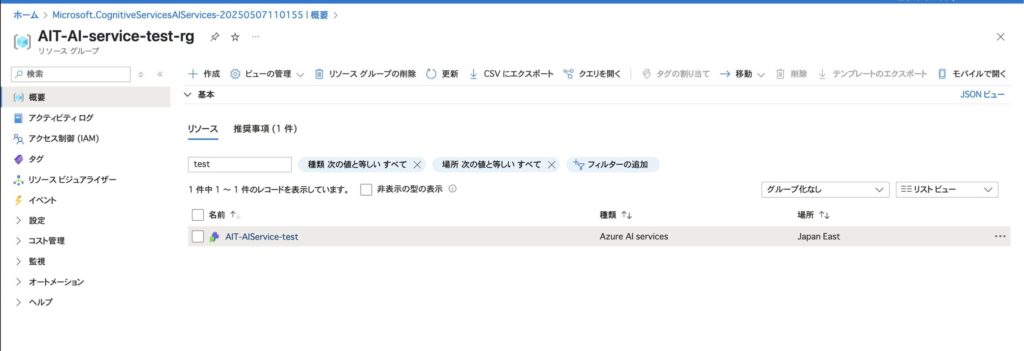

先ほど作成したリソース名が表示されていることを確認し、リソース名をクリックします。

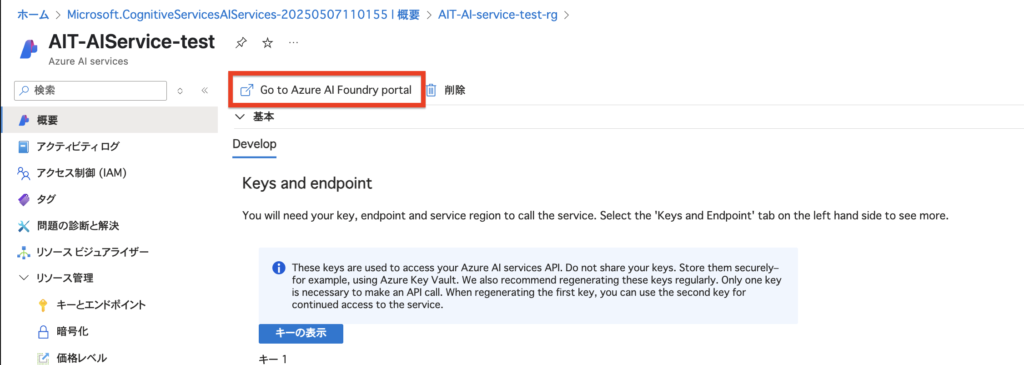

Azure AI Foundryポータルへアクセス

作成したAIサービスの「概要」画面を開くと、「Go to Azure AI Foundry portal」というリンクが表示されています。

このリンクをクリックすることで、Azure AI Foundryの管理ポータルへ直接アクセスできます。

ここから、モデルの構築やデプロイ、評価など高度なAI機能をブラウザ上で操作できます。

Azure AI Foundry Portalでできること

Azure AI Foundry Portal は、Azure 上で提供される生成AI開発のための統合実験環境です。OpenAIの各種モデルを用いて、プロンプト設計、マルチモーダル処理、アシスタント構築などをGUIベースで柔軟に試すことができます。以下では、各機能の役割と用途を詳しく紹介します。

チャット

「チャット」は、GPTシリーズの言語モデルに対してテキストベースのやり取りを行う基本機能です。プロンプトの設計・検証・微調整に最適で、各種パラメータ(温度、トップP、応答長など)をリアルタイムに操作しながらモデルの挙動を確認できます。プロンプトエンジニアリングの初期段階や、軽量なQ&Aボット開発のプロトタイピングに活用されます。

下の画面は、Azure AI Foundryの「チャット」機能を利用し、Azure上の各種サービスをTerraformコードとして自動生成している様子を示しています。

チャットボックスにAzureのサービス名(たとえば「仮想マシン」や「ストレージアカウント」)を入力すると、それに対応するTerraformコードの雛形が即座に生成されます。

アシスタント

「アシスタント」は、チャットの枠を超えてツール機能(例:関数呼び出し、ファイル処理、検索など)を組み込んだ対話型エージェントを構築できる環境です。マルチステップのワークフロー、PDFからの情報抽出、RAG構成のプロトタイピングなど、より実用的な業務向けAIアプリの開発に向いています。GUIベースでTool/Function Callの挙動も確認可能です。

音声(Speech)

Azureの音声AI機能をノーコードで試せるツールです。音声の文字起こし、翻訳、合成(テキスト読み上げ)などをGUIで簡単に操作でき、開発者だけでなく非エンジニアでも利用可能です。

| カテゴリ | 主な機能内容 |

|---|---|

| 音声認識 | リアルタイム文字起こし、音声翻訳、バッチ処理、発音評価 |

| 音声合成 | テキスト読み上げ、アバターによる読み上げ、プロ声のカスタマイズ |

| カスタマイズ | 独自音声データによるモデル調整(Custom Speech) |

| 多言語対応 | 多言語の音声入力・翻訳・出力が可能 |

| 特殊機能 | ビデオ音声の翻訳・音声切替など(シナリオ別機能もあり) |

言語(Language)

言語プレイグラウンドは、テキストデータを使って自然言語処理(NLP)を体験できるツールです。テキストから要約・キーフレーズ・感情・PII(個人情報)などを抽出し、簡単に分析・可視化できます。

| カテゴリ | 機能内容 |

|---|---|

| 情報抽出 | キーフレーズの抽出、PII(個人情報)検出 |

| 情報要約 | 通話やテキスト、会話の要約生成(長文も対応) |

| テキスト分類 | 感情分析(ポジティブ/ネガティブなど)、会話のチャプター分け |

| コールセンター特化 | 顧客とのやり取りから問題と解決の要約抽出 |

オーディオ(Audio)

「オーディオ」では、音声ファイル(.wavや.mp3など)を直接アップロードして、その中身をGPTモデルに処理させることができます。これは単なる音声認識にとどまらず、音声文脈の理解、内容要約、意味抽出などに活用されます。長時間会話の要約や議事録生成、コールセンター音声の分析など、高度な音声活用に対応しています。

| 機能カテゴリ | 内容 |

|---|---|

| AI音声との会話 | マイク入力でAIと自然な音声対話が可能(単語やフレーズで応答) |

| 音声スタイルの選択 | Alloy など複数のAI音声から選択可能 |

| カスタマイズ | プロンプトやパラメータで応答の内容や話し方を調整可能 |

| コンテキスト設定 | AIのトーンや振る舞いを指示するプロンプトを事前に設定可能 |

- 音声(Speech)プレイグラウンド

目的:音声の「分析」や「変換」を行う

- オーディオ(Audio)プレイグラウンド

目的:AI音声との「リアルタイム対話」を体験する

どちらを使うかは「処理したいのか?話したいのか?」で選ぶとわかりやすいです。

画像(Image)

画像プレイグラウンドは、テキストから画像を生成する画像生成AI(主にDALL·Eモデル)を試すためのインターフェースです。プロンプト(指示文)を入力するだけで、AIが対応する画像を生成します。

Azure AI Foundryは、生成AI活用の最短ルート

Azure AI Foundryは、GPTやDALL·E、音声・言語AIといった高度なモデル群を、クラウド上で手軽かつ安全に活用できる統合プラットフォームです。GUIベースのプレイグラウンドを活用することで、プロンプトの試行錯誤からPoC、業務システムへの統合までを一気通貫で加速させることが可能です。

AI開発をより実践的に、効率的に進めたい方にとって、Azure AI Foundryはまさに最適な選択肢。今後ますます進化していく生成AIの波に乗り遅れないためにも、まずはこのFoundryを試してみることから始めてみましょう。